Nascido em 1903, em Frankfurt, Theodor Adorno cultivou desde jovem duas paixões: filosofia e música. Uma área na qual os interesses de Adorno convergiam era sua crítica contra a indústria cultural. Em 1938, durante a ascensão do nazismo na Alemanha, Adorno migrou para os Estados Unidos. Retornou à Alemanha depois do fim da 2da Guerra Mundial assumindo o cargo de professor em Frankfurt.

Adorno acreditava que era um equívoco imaginar que podemos julgar baseados exclusivamente na inteligência, sem emoção. Isso pode ocorrer num tribunal – juízes costumam instruir o júri para deixar a emoção de lado, de modo que possam chegar a uma decisão serena e ponderada. Mas na visão de Adorno, fazer julgamentos criteriosos abandonando a emoção é tão improvável quanto julgar criteriosamente sem o uso da inteligência.

Quando o último traço de emoção for eliminado do nosso pensamento, Adorno escreveu, não restará nada para pensarmos – e a ideia de que a inteligência possa se beneficiar “do declínio das emoções” é simplesmente equivocada. Por essa razão Adorno acreditava que as ciências – enquanto forma de conhecimento que não faz referências às emoções – tiveram um efeito desumanizador sobre nós.

Atualmente um questionamento vem rodando o desenvolvimento das tecnologias emergentes com base na Inteligência Artificial (AI): como podemos construir sistemas inteligentes ética e moralmente robustos que gerem confiança na sociedade?

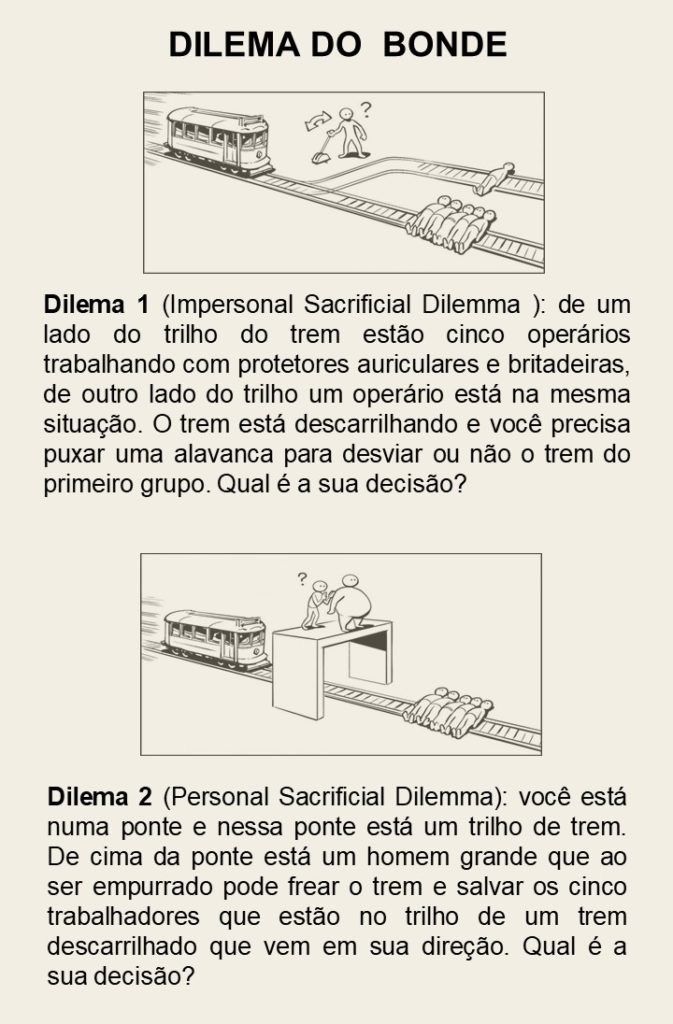

Essa é uma pergunta complexa – nós humanos, temos uma moralidade relativizada em função não somente de questões culturais e religiosas, mas também por uma ótica utilitarista. Um famoso experimento mental demonstra isto – o Dilema do Bonde – proposto pela filósofa Philipa Foot e descrito na figura a seguir:

Pesquisas corroboram que as pessoas acham menos condenável quando você altera o destino do bonde usando um controlador do que quando você empurra alguém nos trilhos para que o trem pare. Avaliando pela lógica pura, esses dilemas não têm diferenças – ambos minimizam a mesma quantidade de sofrimento: as 5 mortes. O que acontece, então?

A chave está no distanciamento oferecido por uma ferramenta, aqui chamada de alavanca, que permite que o ser humano perceba a primeira versão do dilema como menos errada do que a segunda. Ao utilizar um recurso mecânico e, a partir deste, matar uma pessoa temos uma barreira entre o indivíduo e o homicídio, algo que não ocorre ao empurrar alguém diretamente da ponte.

Para o filósofo e psicólogo evolutivo Joshua Greene, ao longo dos milênios criamos instintos sociais que nos refreiam na hora de matar alguém. Acontece que, na maior parte do tempo da nossa evolução, vivemos em cavernas e com lanças na mão, e não operando máquinas, botões ou alavancas. Isso faz com que nossos instintos sociais não relacionem o ato de apertar um botão ou puxar uma alavanca com o de jogar alguém para a morte – é por esse motivo que, para Joshua Greene, tanta gente mudaria a alavanca na situação anterior, mas não executaria o homem neste segundo dilema. “Os instintos sociais refletem o ambiente nos quais eles evoluíram, não o ambiente moderno”, afirma o cientista.

Nossa moralidade natural tem bases arcaicas e, portanto, deficiente diante da nova onda tecnológica da Inteligência Artificial. A AI é essa “alavanca” dos novos dilemas que surgem na nossa sociedade, e se não ficarmos atentos pode nos deixar anestesiados. Precisamos nos proteger criando uma Moral Artificial ou digital que nos complemente e nos ajude a dar contornos e limites à AI. Não encarem o termo “Artificial Morality” de forma depreciativa, sinônimo de uma falsa moral, e sim de forma análoga ao termo amplamente usado de “Artificial Intelligence” que descreve tecnologias que incrementam nossa inteligência natural e não de uma falsa inteligência.

Alguns dos novos dilemas já começam ficar evidentes, por exemplo:

-Imagine ficar revisando o lixo do vizinho para saber o que compra, o que come, o que lê, com que dorme… isso seria moralmente inadmissível, mas não é isso o que fazemos normalmente usando os algoritmos que capturam e processam todo o “lixo” que geramos como internautas? O sigilo das informações é um dos temas mais discutidos atualmente e para o qual já surgem proteções como a Lei Geral de Proteção de Dados.

-Ficamos indignados quando vemos casos de preconceitos, mas não seria a mesma coisa que gerar modelos analíticos com amostras de dados viesadas, ou com variáveis discriminatórias como raça e religião?

-Exigimos das pessoas explicações transparentes, mas aceitamos quando por exemplo o banco nega o empréstimo com base num determinado score, um número que aparentemente construído por um algoritmo inteligente sem uma devida explicação do motivo da recusa, nem da metodologia usada no cálculo.

-O carro autônomo é talvez o exemplo mais nítido da necessidade de uma Moral Artificial. Você compraria um carro autônomo que em um momento crítico de colisão com uma criança a prioridade seja você? Será que precisaremos no futuro escolher os carros pela moralidade programada neles?

A massificação de sistemas inteligentes é uma realidade e sem dúvida trará enormes benefícios aos seres humanos. Mas essa implementação deve estar guiada por uma visão moral… a Inteligência Artificial deve ser encarada necessariamente – como proferia Adorno – como uma categoria moral.■

Se gostou do conteúdo, compartilhe! As outras pílulas estarão AQUI. E para ser avisados acompanhe dando um Follow em nosso perfil!